M5Stack���g���Ă݂� (MicroPython��)

Introduction

���ꂼ��R���p�N�g�ȃP�[�X�ɑ�R�̋@�\���l�܂������͓I��IoT�f�o�C�X

�}�C�R������̂ЂƂ�M5�ƒ�����SORD m5���v���o���͂�w

���e��Index�ɂ܂Ƃ߂Ă��܂��B���D�݂̓��e���܂�����Ƃ����������B(^_^)

�قڔ��Y�^�ł��B�o�[�W�����Ȃǂ̈Ⴂ�ɂ���Ďg�������ς���Ă���\��������̂ł����ӂ��������B

�����Ȃ����̂��n�[�h�҂͕ʃy�[�W�ɂ܂Ƃ߂܂����B

���J���Ă�����e�҂ɖ��f�œ]�ڂ��邢�͏��ƖړI�ŗ��p���邱�Ƃ��֎~���܂��B �������͌l�̐ӔC�̂��Ƃɍs���ĉ������B�����������́A�̏�Ȃǂɑ��Ĉ�̐ӔC�������܂���B ���J���Ă�����e�̃A�C�f�A�𗬗p������i�A����ь��J���Ă���Ǝ��̉�͌��ʂ��܂ޏ����ASNS�A�u���O�A���ЂȂǂŔ��\����ۂ͂���������B������̃T�C�g�ւ̃��t�@�����X(�����N)�������Ă��������B

�����ɂ��d�g�@�ᔽ�ƂȂ�\��������܂��B���T�C�g�ł͓K���A�d���g�R�k����s���Ă���d�g�@�̓K�p�͈͓��Ŏ������Ă��܂��B�����͎��ȐӔC�ł��肢���܂��B �Z�K(�H���v�F��)�Ɋւ����� ��

Index

MicroPython��

- �E M5Stack (M5Stick / M5Atom / M5Camera / M5Stamp) ��MicroPython�Ŏg���Ă݂�B

- �E MicroPython [ original���r���h�� ]

- �E MicroPython [ loboris���r���h�� ]

- �E MicroPython�ŃT�E���h���g���Ă݂�B

- �E MP3�t�@�C����������

- �E WAVE�t�@�C����������

- �E �}�C�N���g��

- �E MicroPython�ŃO���t�B�b�N���g���Ă݂�B

- �E �t���f�B�X�v���C���g�� [ original���r���h�� ]

- �E �t���f�B�X�v���C���g�� [ original���r���h��[S3] ]

- �E �t���f�B�X�v���C���g�� (framebuf)

- �E �t���f�B�X�v���C���g�� [ loboris���r���h�� ]

- �E �t���f�B�X�v���C���g�� [ loboris���r���h�� + LovyanGFX ]

- �E �C���[�W�f�[�^��A���\������

- �E MicroPython�Ńt�@�C���V�X�e�����g���Ă݂�B

- �E SD�J�[�h���}�E���g����

- �E SPI�C���^�[�t�F�[�X���g���ۂ̃g���u������

- �E MicroPython�ŃZ���T�[���g���Ă݂�B

- �E �W���C���X�A�����x�A�n���C�Z���T���g��

- �E Madgwick�t�B���^���g��

- �E MicroPython��Bluetooth���g���Ă݂�B

- �E Bluetooth(Classic)���g�� [ loboris���r���h�� + btstack ]

- �E sixaxis (DUALSHOCK3)

- �E spp[Server] (Serial Port Profile)

- �E spp[Client] (Serial Port Profile)

- �E hid (Wii Remote/Other)

- �E hid[Slave] (Keyboard/Mouse)

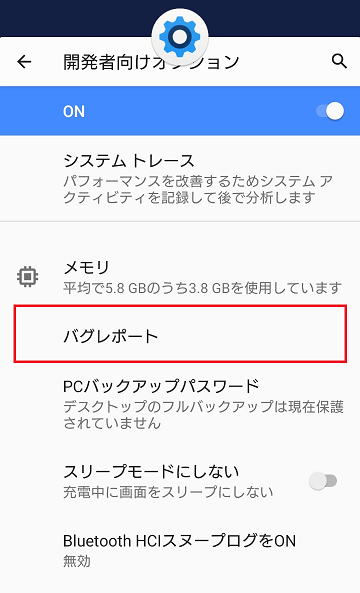

- �E hci�p�P�b�g��Android�ŃL���v�`�����ĉ��

- �E Bluetooth(BLE)���g�� [ original���r���h�� ]

- �E BLE Keyboard

- �E MicroPython�Ńl�b�g���[�N���g���Ă݂�B

- �E Wi-Fi �A�N�Z�X�|�C���g�ɐڑ�����

- �E FTP�T�[�o�[�ɐڑ�����

- �E MicroPython��CPU������g���Ă݂�B

- �E DeepSleep���g��

- �E ����N���b�N��ύX����

- �E MicroPython�Ńf�o�C�X���g���Ă݂�B

- �E PMIC���g��

- �E RTC���g��

- �E �J�������g��

- �E DualShock/2���g��

- �E MicroPython��WebAPI���g���Ă݂�B

- �E Google Cloud Speech-to-Text ��WebAPI�Ŏg��

- �E ChatGPT AI�`���b�g�{�b�g��WebAPI�Ŏg��

- �E VOICEVOX��WebAPI�Ŏg��

�n�[�h��

- �E M5Stack / M5GO

- �E �h���[��Tello��M5Stack�Ŕ���Ă݂܂����B(�o�C�i���[���[�h)

- �E M5Stack�p�̃��[�^�[���W���[�������삵�Ă݂܂����B

- �E �p�`�p�`�N���b�s�[[�g�[���N]���������ɂ��܂����B

- �E New AIBO���̃V�b�|��t���܂����B

- �E �p�`�p�`�N���b�s�[[�g�[���N]�̖ڂ��悤�ɂ��܂����B

- �E M5Stack WALL-E�������܂����I

- �E M5Stack�ʼnƂ̃h�A�����C�h�J�t�F���ɉ������Ă݂��B

- �E M5Stack�œ���Đ�

- �E M5Stack�p�̃v���g���W���[���P�[�X

- �E M5Stack�̃X������+�o�b�e���[�e�ʃA�b�v

- �E Stack-chan �T�C�h���| �|�P�b�g��

- �E M5Camera

- �E M5StickC

- �E M5StickC�̉��

- �E M5StickC�̃g���u����

- �E M5StickC�̓d�����M�����[�^(DCDC)�ׂĂ݂�B

- �E M5StickC PLUS�ŕς�����Ƃ���

- �E M5StickC �����o�b�e���[�̉ߕ��d��� (ERROR 22)

- �E M5Frisk������Ă݂��B

- �E M5StickC�̊O�t���o�b�e���[������Ă݂��B

- �E M5StickC�����S �}�C�N���X�J�E�g(LEGO 9748)�ɂ���Ă݂��B

- �E M5StickC�Ń��S �t�B�A�b�g500(LEGO 10271)�𑖂点�Ă݂��B

- �E M5Atom-Lite / M5Atom-Matrix / M5Atom-Echo

- �E M5Atom�̉��

- �E M5Atom�̃o�b�e���[������Ă݂��B

- �E M5Atom Lite��9���Z���T�[��lj����Ă݂��B

- �E M5Atom�̃��S�}�E���^������Ă݂��B

- �E M5Atom WALL-E�������܂����I

- �E M5Atom 2�����s���{ NanoWalker U800

- �E M5Stack Japan Creativity Contest 2020��NanoWalker U800�����܂��܂����I

- �E NanoWalker U800�ɏ�������S�̃~�j�t�B�O�Ƀ��C�g�Z�[�o�[��U���Ă݂܂����B

- �E M5Atom�Ńv�b�V���t�H���^�L�[�{�[�h������Ă݂�

- �E M5Atom�ŃT�[�}���v�����^�Ɉ�����Ă݂�

- �E M5Atom�ŃL�r�L�r����NanoRolling������Ă݂��B

- �E M5Atom�Ń~�j�t�B�O�����Ă݂��B

- �E M5AtomS3�̉��

- �E M5AtomS3�ł�NanoRolling���o�[�W�����A�b�v���Ă݂��B

- �E M5Atom�V���[�Y�p�̃~�j�t�B�O�A�_�v�^

- �E M5Stamp

- �E M5Stack�i���݁j�T�|�[�g�Z���^�[

- �E �t�@�[���E�F�A�̃o�b�N�A�b�v / ���X�g�A

- �E M5Stack / M5Stick / M5Camera��I2C(Grove)�R�l�N�^

- �E Other

M5Stack (M5Stick / M5Atom / M5Camera / M5Stamp) ��MicroPython�Ŏg���Ă݂�B

| MicroPython�̎�� | �x�[�X�o�[�W���� | idf | �֘A�T�C�g | �\�[�X�R�[�h | M5�n�[�h�Ή� |

| �{�� | v1.25.0 preview | v5.4 | micropython.org | �\�[�X�R�[�h | �� |

| original���r���h�� | v1.24.1 | v5.1.2 | ���̃y�[�W�ʼn�� | �� | |

| loboris | v1.9.4 | v3.1.x | �\�[�X�R�[�h | �� | |

| loboris���r���h�� | loboris | v3.2.x | ���̃y�[�W�ʼn�� | �� | |

| UIFlow | v1.12 | v4.x.x | flow.m5stack.com | ����J | �� |

| UIFlow2 | v1.24.0 | v5.0.4 -5.2.2 | flow2.m5stack.com | �\�[�X�R�[�h (���[�J����) | �� |

| Core2forAWS-MicroPython | v1.12? | v4.x.x | �\�[�X�R�[�h | Core2forAWS�̂� |

- �E �ŐV��MicroPython�̏��̓����[�X�m�[�g�Ŋm�F���Ă��������BReleases

- �E �J�X�^���@�\���������Ƃ���[ original���r���h�� ]�A[ loboris���r���h�� ]�A[ loboris ]�ƋL�ڂ����Ă��܂��B

- �E MicroPython�̎�ނ�o�[�W�����ɂ��A���ꂼ��@�\����������Ă��Ȃ�������A���@���قȂ�܂��B �Ⴂ�������Ă��@�\����������Ă���A���̂܂܁A�������͎�̎蒼���őΉ��ł���ꍇ������܂��B

- �E [ loboris���r���h�� ]�͍��@�\��[ loboris ]�ɂ���ɋ@�\��lj����Ă��܂��B�x�[�X�͌Â��Ȃ��Ă��܂�������x�������̂ŗp�r�ɂ���Ă͂܂��܂��g���܂��BBluetooth Classic�ɗB��Ή����Ă��܂��B

- �E Python��IDE�Ƃ���uPyCraft ���g���Ă��܂��B

Thonny�̓t�@�C���i�摜�Ȃǂ̃o�C�i���܂߁j�̃h���b�N�h���b�v�]�����g���Ȃ��̂Ŏg���Ă��܂���B - �E M5Stack�����ł�UIFlow�𐄏����Ă��܂��BREPL����قڒʏ��MicroPython�Ƃ��Ă��g���܂��B

MicroPython [ original���r���h�� ] Index

Index

�ŐV�̃I���W�i��MicroPython(v1.24.1)��M5Stack(Core2/Fire/M5Atom[S3]/M5Stamp[S3])�ɍœK�����ă��r���h���܂����I���ꂩ��@�\���[�������Ă䂫�܂��B�lj������@�\

�@ M5Stack Core2 / Fire / M5Atom[S3] / M5Stamp[S3] / M5StickC[PLUS/2] �̃n�[�h�E�F�A�ɑΉ�

�A MP3�t�@�C���̍Đ��ɑΉ��i�o�b�N�O���E���h�Đ��ɑΉ� [�X���b�h�Z�[�t] �j

�B Madgwick�t�B���^�ɑΉ��iC�v���O�����Ȃ̂ō����j

�C Bluetooth�ɑΉ� (BLE HID���ȒP�Ɏg����悤�ɂ��܂���)

�D I2S�̃T�E���h��PDM�ɑΉ�

�E REPL��uPyCraft�̃o�C�i���]���ɑΉ�

�F ESP32S3��ESP_LOGx��REPL�\���ɑΉ�

�@ expand.logview(True) �����s���閳��ESP32�Ɠ��l��REPL��ESP_LOGx���\������܂��B

�G PWM�̃p�[�Z���g�w��ɑΉ�

�@ machine.PWM.reserve(percentage=True) �����s�����loboris�݊��ɂȂ�܂��B

MicroPython [ original���r���h�� ] �r���h�ς݃C���[�W�t�@�C��

���r���h�ς݂̃C���[�W�t�@�C����p�ӂ��܂����IMicroPython[ original���r���h�� ] M5Stack[Fire/Core2/Basic]/M5Atom[S3]/M5Stamp[S3]/M5StickC[+2]/XiaoS3[C3]�Ή� �_�E�����[�h

- �� �������̃��r���h�łł��邱�Ƃ��������̂����ł��g�����������Bv1.24.1�ł͖��m�F�̋@�\������܂��B

- �� �������݂̓n�[�h�҂��t�@�[���E�F�A�̃o�b�N�A�b�v / ���X�g�A���Q�Ƃ��Ă��������B

BOARD���̍쐬

�{�[�h����p�ӂ���ƃ{�[�h���ƂɃr���h���邱�Ƃ��o����̂ŕ֗��ł��Bboards�ȉ��Ƀ{�[�h���̃t�H���_�����܂��B���W���[���̒lj�

���r���h [���l�u��]

MicroPython [ loboris���r���h�� ] Index

Index

����ł͂ǂ�MicroPython�ł��g���Ȃ��@�\�����邽�߁A���̂Ƃ���@�\���L�x��loboris�ł�M5Stack(M5Sstick/M5Atom/M5Stamp)�ɍœK�����ă��r���h���܂����I

�lj������@�\

�@ M5Stack / M5Stick / M5Atom / M5Stamp �̃n�[�h�E�F�A�ɑΉ�

�A MP3�t�@�C���̍Đ��ɑΉ��i�Đ�����SD�ALCD�̓����A�N�Z�X���\�j ��

�B Madgwick�t�B���^�ɑΉ� ��

�C Bluetooth�ɑΉ� (btstack�̈ꕔ�̋@�\) ��

�D �o�b�t�@�Ɋi�[���ꂽ�C���[�W�f�[�^�̕\���ɑΉ�

�E readinto���g�����Ƃ��Ƀf�[�^�i�[�ʒu���I�t�Z�b�g�w��ł���B

�F WAV�t�@�C���̍Đ����Ƀo�b�t�@�[�e�ʂ��w��ł���B

MicroPython [ loboris ] �r���h�ς݃C���[�W�t�@�C��

MicroPython[ loboris���r���h��> ] �_�E�����[�h- �� �������̃��r���h�łł��邱�Ƃ��������̂����ł��g�����������B

- �� �������݂̓n�[�h�҂��t�@�[���E�F�A�̃o�b�N�A�b�v / ���X�g�A���Q�Ƃ��Ă��������B

- �� FLASH�T�C�Y/SPI���x/PSRAM�ʂɂȂ��Ă��܂��B

- �� ���O��btstack������t�@�C����Bluetooth�̈ꕔ�@�\���g���܂��������o�[�W�����ł��Bbtstack�����������L���邽�ߗ��p�\�������������Ă��܂��B(PSRAM�����ڂ���Ă��Ȃ���WiFi���g���܂���)

���r���h [���l�u��]

MicroPython�ŃT�E���h���g���Ă݂�B

MP3�t�@�C���������� Index

Index

MP3�t�@�C���̍Đ��@�\��lj����܂����B�o�b�N�O���E���h�Đ����o����̂ōĐ������������p���ł��܂��B������

- �� I2S�̃`�����l����2�`�����l������܂����A�Đ�/�^���ł̓`�����l��0�����g���܂���B�܂��Đ�/�^���͓����ɂ͎g���܂���B

��

audio.play_mp3('�t�@�C����.mp3') �t�@�C���f�B�X�N���v�^�̎w����o���܂�

�I�v�V����(�ȗ��A�l�͏����l)

port_id=0,

buffsize=1940, ���[�h�o�b�t�@�isocket�X�g���[������̍Đ����ȂǁA���ꂷ��ۂ͑��₵�܂��j

bg_play=False, stacksize=4096, priority=2, core=1, �o�b�N�O���E���h�Đ��̎w��

bit=32, I2S���r�b�g�T�C�Y�i��������p�j

stream=False, True �ɂ���ƃw�b�_��ǂݍ��܂Ȃ�

end_mute=False, �Đ���̏����i�m�C�Y��j

button=None, button_on=False ��~�{�^���A��~�{�^��ON����

audio.check_play() ���m�F

audio.stop() ����~

audio.interrupt_in() �q�X���b�h�̃t�@�C���A�N�Z�X���~

audio.interrupt_out() �q�X���b�h�̃t�@�C���A�N�Z�X���ĊJ

- �� �o�b�N�O���E���h�Đ�����ۂ̓t�@�C�����ł͂Ȃ��t�@�C���f�B�X�N���v�^���g���K�v������܂��B

- �� esp32�̕W���r���h���ꂽ�t�@�C���V�X�e���̓X���b�h�Z�[�t�ł͂���܂���B

�X���b�h�Z�[�t�ɑΉ����邽�߂Ƀ\�[�X�R�[�h�����ς��Ă��܂��B

- �� �o���邾���Z���ԂŊ��荞�ݏ������I�������܂��B

- �� �Đ����Ɏ��s�����t�H�A�O���E���h�̃v���O�����ɂ���Ă͗\�����ʓ��������\��������܂��B

�ϊ��c�[����EcoDecoTooL114���g���Ă��܂�(Fraunhofer/CBR/128kbps)

WAVE�t�@�C���������� Index

Index

audio.play_wave('�t�@�C����.wav') �t�@�C���f�B�X�N���v�^�̎w����o���܂�

�I�v�V����(�ȗ��A�l�͏����l)

port_id=0,

buffsize=1024, �o�b�t�@�[�T�C�Y

bg_play=False, stacksize=4096, priority=2, core=1, �o�b�N�O���E���h�Đ��̎w��

bit=32, I2S���r�b�g�T�C�Y�i��������p�j

repeat=0, ���s�[�g����

end_mute=False �Đ���̏����i�m�C�Y��j

button=None, button_on=False ��~�{�^���A��~�{�^��ON����

audio.check_play() ���m�F

audio.stop() ����~

�}�C�N���g�� Index

Index

������

- �� I2S�̃`�����l����2�`�����l������܂����A�Đ�/�^���ł̓`�����l��0�����g���܂���B�܂��Đ�/�^���͓����ɂ͎g���܂���B

�^��

���ɔ������Ď����Ř^�����܂��B�^���J�n�ɕK�v�ȉ��ʂ̓��[�p�X�A�}�C�N���x���Őݒ肵�܂��B�^���f�[�^�̓t�@�C���ɂ��ۑ��ł��܂��i���X�|���X�������܂��j

buff = bytearray(framerate*10+44) # 10 Sec

rec_size= wave.mic_recording_auto(mic, �^���f�[�^�̊i�[�ꏊ�i������ / �t�@�C�����jbuff,

�t���[�����[�g12000, ���[�p�X8, �}�C�N���x��6)

�I�v�V����(�ȗ��A�l�͏����l)

chunk_size=6000, �^���̍ŏ��P�ʁi�t���[�����[�g�̔������w�肷���0.5�b�j

block_size=48000, �����F�����������ŏ��P�ʃu���b�N�P�ʁi�ʏ�t���[�����[�g��4�{�j

sc=3, nc=2, debug=False, cv=False, shift=0

MicroPython�ŃO���t�B�b�N���g���Ă݂�B

�t���f�B�X�v���C���g�� [ original���r���h�� ] Index

Index

������

M5Stack Core2 / Fire��LCD��SD������SPI�o�X�ɐڑ�����Ă���̂ŁA���p�o����悤��"russhughes/st7789_mpy"���C�����Ă��܂��B

�}���`�v���b�g�t�H�[���Ȃ̂�M5Stack�̃n�[�h�E�F�A�ɓ������Ă��Ȃ��̂��Ǝv���܂��B

�t���f�B�X�v���C���g�� [ original���r���h��[S3] ] Index

Index

������

�`��Ȃǂ̎g�����͂�������Q�Ƃ��Ă��������B�� ESP_LCD MicroPython driver for ESP32-S3 Devices with ST7789 or compatible displays.

�t���f�B�X�v���C���g�� (framebuf) Index

Index

������

�t���f�B�X�v���C���g�� [ loboris���r���h�� ] Index

Index

������

�`��

�ڂ����́c display�Eloboris/MicroPython_ESP32_psRAM_LoBo Wiki�EGitHub�t���f�B�X�v���C���g�� [ loboris���r���h�� + LovyanGFX ] (2020/08/07-) Index

Index

lovyan03����̒������O���t�B�b�N���C�u����LovyanGFX��MicroPython�ł��g����悤�ɂ��܂����Bdisplay���W���[���Ƌ����o���܂���A�ʓr���r���h���K�v�ł��B

MicroPython[loboris+lovyan03���r���h��] �_�E�����[�h (�����o�[�W����)

- �� MicroPython�Ή��ɂ�������lovyan03����ɂ��Ή������܂����B���̏����Ċ��Ӑ\���グ�܂��B

������

LovyanGFX�ŃC���[�W�f�[�^��\������

lgfx.drawJpg(data, 0, 0) �o�b�t�@�Ɋi�[���ꂽ�C���[�W�f�[�^,x, y�̈ʒu�w�肪�o���܂�

�C���[�W�f�[�^��A���\������ (2019/04/09-) Index

Index

M5Stack [ loboris���r���h�� ]

MicroPython�Ńt�@�C���V�X�e�����g���Ă݂�B

SD�J�[�h���}�E���g���� Index

Index

������

SPI�C���^�[�t�F�[�X���g���ۂ̃g���u������ Index

Index

ESP32���W���[���ɂ�HSPI�AVSPI(ESP32��C/S���Ƃ��ꂼ��SPI2_HOST=1�ASPI3_HOST=2)��2�n����SPI�C���^�[�t�F�[�X���p�ӂ���Ă��܂��B�iFlash��psRAM�p�͕ʁj

M5Stack Core2 / Fire / Basic

SD�J�[�h�X���b�g��LCD�̓C���^�[�t�F�[�X(VSPI)�����L���Ă��܂��B�O���pSPI�[�q��VSPI�ɐڑ�����܂��BSD�J�[�h��LCD���ɃA�N�Z�X����ۂɂ͒��ӂ��K�v�B

MicroPython [ loboris ] �ł�SPI��DMA

SPI��DMA���g�p���Ă���MicroPython [ loboris ] �ł͌��L�ɌŒ肳��Ă��܂��B- �E LCD (DMA1)

- �E SD�X���b�g (DMA2)

- �E �O��SPI�@�� (DMA1)

[SPI_UTILS]: spi initialization failed with rc=0x103

MicroPython�ŃZ���T�[���g���Ă݂�B

�W���C���A�����x�A�n���C�Z���T���g�� Index

Index

�Ȃ�ׂ����ʉ��ł���悤�Ƀv���O�������L�q���Ă��܂��B�ݒ�l�͊e�Z���T�[�̎d�l�ɂ��܂��B

Madgwick�t�B���^���g�� [ original���r���h�� / loboris���r���h�� ] Index

Index

Madgwick�t�B���^���g�����ɂ�胍�[���A�s�b�`�A���[�p�������x�Ɏ擾�ł��܂��B- �� �Z���T�[���L�����u���[�V��������Ă��Ȃ��ƃh���t�g���܂��B

MicroPython��Bluetooth���g���Ă݂�B

Bluetooth(Classic)���g�� [ loboris���r���h�� + btstack ] (2019/08�`) Index

Index

Bluetooth�Ɋւ�����͏��Ȃ��̂�MicroPython�Ɏ�������̂͋�J���܂����B���W���[����������Ă��܂����Ƃ̈����͊ȒP�ł��B

���܂̂Ƃ���btstack�Ƃ̑g�ݍ��킹���ƂĂ����肵�Ă܂��Bbtstack�͓o�ꂩ�炩�Ȃ�o���Ă��邱�Ƃ���������������������ă\�[�X�R�[�h���ǂ݂₷���A�T���v���R�[�h���[�����Ă��܂��B�ł�API�\��(BLE ANCS Client API)���Ǝ��Ȃ̂�MicroPython�̃��W���[���ɂ���̂͂�����Ɩʓ|�ł��B����MicroPython(ESP32)��Bluetooth(BLE)�ɑΉ����܂����B�N���V�b�N�ɂ͑Ή����ĂȂ��悤�ł��B����btstack���g���K�v��������Ă��邩������܂���B

- �� Callback���[�`�����ł̃������m�ۂ̓G���[�̗v���ɂȂ�܂��Bglobal�̎g�p�𐄏����܂��B

- �� run_loop_execute()���g����Python�ɐ��䂪�߂�Ȃ����߁Arun_noloop_execute(timeout_ms)��lj�

sixaxis (DUALSHOCK3)

DUALSHOCK3�̃f�[�^�ڎ擾���邱�Ƃ��o���܂��B- �� DUALSHOCK3��PlayStation�ȊO�Ŏg�����߂ɂ͎��O�̏������K�v�ł��B

Windows�̏ꍇ�́A������Ѓx�X�g�e�N�m���W�[�����SIXAXIS�̐ݒ����ڂ����ł��B

��L�����N����擾�ł��� sixpair ���g���ăz�X�g��(M5xxxxx)��MAC�A�h���X�� DUALSHOCK3�ɏ������݂܂��B �z�X�g����MAC�A�h���X�͉��L�� sixaxis.read_mac() �Ŏ擾�ł��܂��B

USB ���̓f�o�C�X�ŔF������Ă���Ƃ���DUALSHOCK3�Ƃ��ĔF������Ă��܂���A���܂��ڑ��o���Ȃ��Ƃ���DUALSHOCK3�����Z�b�g���܂��B

spp[Server] (Serial Port Profile)

���z�V���A���|�[�g�Ƃ��ē��삵�܂��BPC���̐ݒ�͒��M�i�f�o�C�X���ڑ����J�n����jspp[Client] (Serial Port Profile)

���z�V���A���|�[�g�Ƃ��ē��삵�܂��BPC���̐ݒ�͔��M�i�R���s���[�^���ڑ����J�n����jhid (Wii Remote/Other)

Wii�����R���Ȃǂ�HID�^�C�v�̃Q�[���R���g���[������f�[�^�ڎ擾���邱�Ƃ��o���܂��Bhid[Slave] (Keyboard/Mouse)

HID�̃X���[�u��������܂��B�L�[�{�[�h�A�}�E�X�Ƃ��ċ@�\���܂��Bhci�p�P�b�g��Android�ŃL���v�`�����ĉ��

Bluetooth(BLE)���g�� [ original���r���h�� ] (2023/04�`) Index

Index

ESP32S3����Classic�͔�Ή��ɂȂ�BLE�̂ݑΉ��ƂȂ�܂����BAPI��NimBLE�x�[�X�ɂȂ��Ă��܂��B

BLE Keyboard

AtomS3��BLE Keyboard�ɂ����ł��BHeerkog����hid_services.py��g�ݍ���ł��܂��B

�I���W�i��UUID�̐���

������Ő����ł��܂��Bversion1���w�� https://www.uuidgenerator.net/version1MicroPython�Ńl�b�g���[�N���g���Ă݂�B

Wi-Fi �A�N�Z�X�|�C���g�ɐڑ����� Index

Index

import network

import setting SSID,PASSWARD��ۑ������ݒ�t�@�C��

if 'ap_if' not in locals():

ap_if = network.WLAN(network.STA_IF)

if not ap_if.isconnected():

ap_if.active(True)

ap_if.connect(setting.MY_SSID, setting.MY_PASSWARD)

while not ap_if.isconnected(): �ڑ��҂�

print(".", end='')

time.sleep(0.1)

FTP�T�[�o�[�ɐڑ����� Index

Index

[ original���r���h�� ]

ftp.ftpserver()

�ȈՃo�[�W�����ł��B�N���C�A���g���Z�b�V���������ƏI���B1 �̃Z�b�V�����݂̂��T�|�[�g����܂��B

MicroPython��CPU������g���Ă݂�B

DeepSleep���g�� Index

Index

DeepSleep���͏���d�͂�ߖ�ł��܂��B

����N���b�N��ύX���� Index

Index

����N���b�N�ɂ�2MHz, 80Mhz, 160MHz, 240MHz���w��ł��܂��B

machine.freq(240) �C�ӂ̓���N���b�N���w��A�ȗ������ꍇ�͌��݂̃N���b�N��Ԃ��܂��B

- �� DeepSleep�ƈႢ�N���b�N�ύX��ł����̂܂܃v���O���������삵�܂��B�������ʐM�n�̋@�\���g���Ă���ꍇ�Ȃlje�����N����\��������܂��B

- �� loboris�ȊO�ł�MHz�̎w�肪�o���Ȃ��悤�ł��B240MHz��240000000Hz�ɂȂ�܂��B

MicroPython�Ńf�o�C�X���g���Ă݂�B

PMIC���g�� Index

Index

MicroPython����p���[�}�l�W�����gIC AXP192�ɃA�N�Z�X����Bi2c = machine.I2C(sda=21, scl=22)

pm=axp192.AXP192(i2c)

RTC���g�� Index

Index

MicroPython���烊�A���^�C���N���b�NBM8563�ɃA�N�Z�X����Bi2c = machine.I2C(sda=21, scl=22)

rtc=bm8563.BM8563(i2c)

rtc.GetBm8563Time() (�N, ��, ��, ��, ��, �b, �T)���߂�܂��B

rtc.GetTime() (��, ��, �b)���߂�܂��B

rtc.SetTime(Hours, Minutes, Seconds) ���Ԃ�ݒ肵�܂��B

rtc.GetData() (�N, ��, ��, �T)���߂�܂��B

rtc.SetData(Year, Month, Date, WeekDay) ���t��ݒ肵�܂��B

�J�������g�� Index

Index

DualShock/2���g�� Index

Index

DualShock/2��SPI�C���^�[�t�F�[�X�ŒʐM�ł��܂��BDualShock/2�̎����͂����炪�ڂ����ƂĂ�������₷���ł��B

�v���C�X�e�[�V����2��p���[�����O�X�C�b�`�Z�p����

������

MicroPython��WebAPI���g���Ă݂�B [ original���r���h�� ]

�T���v���R�[�h�̎��s�ɂ̓��r���h�ς݂̃C���[�W�t�@�C�����K�v�ɂȂ�܂��B

MicroPython�����r���h�������Q�Ƃ��Ă��������B

Google Cloud Speech-to-Text ��WebAPI�Ŏg�� (2024/01�`) Index

Index

wave�f�[�^�̐������}�C�N���g�����Q�Ƃ��Ă��������B- �� �������̂��߃������Ɋi�[����wave�f�[�^�����̂܂�Base64�G���R�[�h���ē]�����Ă��܂��B

Base64�G���R�[�h��chunk_size���Ƃɕ������čs�����ƂŃ�������啝�ɐߖĂ��܂��B - �� �^�����Ԃ�L�������A�������͓��ڃ����������Ȃ����wave�f�[�^���t�@�C���o�R�ň����K�v������܂��B

ChatGPT AI�`���b�g�{�b�g��WebAPI�Ŏg�� (2023/04�`) Index

Index

VOICEVOX��WebAPI�Ŏg�� (2023/04�`) Index

Index

VOICEVOX�T�[�o�[�̋N�� (Windows)

VOICEVOX�T�[�o�[�ւ̃��N�G�X�g

import webapi �T�|�[�g���W���[��

address="VOICEVOX�T�[�o�[�̃A�h���X:50021/"

res1 = requests.post(address+'audio_query?text='+webapi.encode_url_string(content)+'&speaker=1&outputStereo=false')

res2 = requests.post(address+'synthesis?speaker=1&outputStereo=false',data = res1.text.encode("utf-8"))

�L�����N�^�[�{�C�X��ς���Ƃ���speaker�̒l��ς��܂��B

webapi.play_wav(res2.raw, spk) # !caution instance variable �C���X�^���X�ϐ����Q�Ƃ��Ă���̂ŗv����

- �� wave�f�[�^���o�b�t�@������ɒ���I2S�ɏ������݂��邱�ƂŃ�������ߖč��������Ă��܂��B

Attic or Garret ���̊e�L���C�ʐ^�y�щ������e�҂ɖ��f�œ]�ڂ��邢�͏��ƖړI�ŗ��p���邱�Ƃ��ւ��܂��B

Copyright © 1996-2021 Itoi.All Rights Reserved.